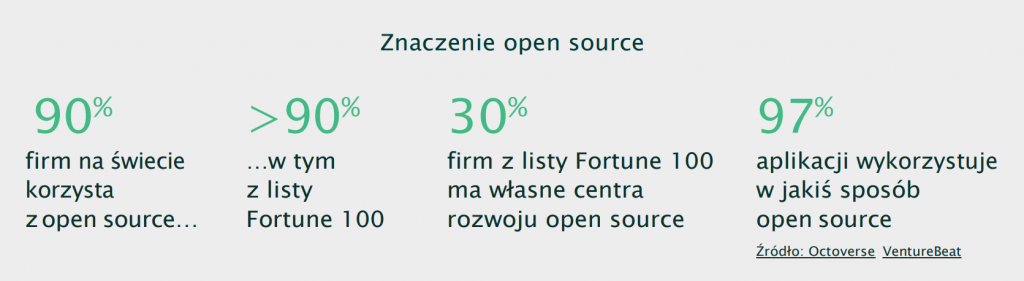

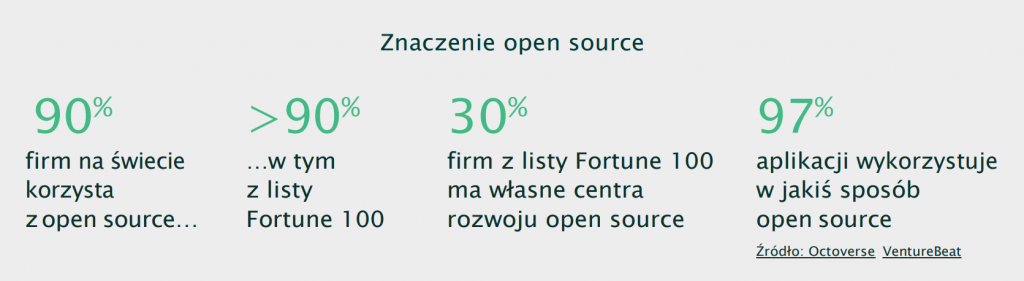

Oprogramowanie open source stało się kluczowym elementem nowoczesnych środowisk IT. Firmy korzystają przede wszystkim z systemów Linux – największego projektu open source, który napędza ich operacje biznesowe. Co za tym idzie, organizacje są zależne od zdrowego, dobrze prosperującego ekosystemu open source skupionego wokół Linuksa, ale także całej gamy innego oprogramowania i narzędzi.

Linux i oprogramowanie open source stanowią kluczowy element większości obecnych strategii transformacji cyfrowej, od chmury hybrydowej i rozwiązań wielochmurowych po kontenery i mikrousługi. Mają absolutnie fundamentalne znaczenie dla każdej firmy wykorzystującej najnowsze technologie do rozwoju swojej działalności. Jednak za sukcesem Linuksa i ogólnie open source nie stoi tylko jego wartość biznesowa, ale przede wszystkim wspierająca go społeczność i sposób rozwoju otwartego oprogramowania.

To właśnie sprawia, że open source jest dziś tak ważny dla przedsiębiorstw. Główne zasady open source, takie jak współpraca i wspólny sukces, są dobre dla wszystkich. Musimy bronić tych wartości i zadbać o dobro społeczności open source dla przyszłych pokoleń. Organizacje, które czerpią korzyści ze społeczności open source, mają szczególny obowiązek zwrócenia tyle samo, ile otrzymują.

Tak właśnie działamy w SUSE od 30 lat. Jesteśmy zaangażowani zarówno w rozwój open source, jak i jego społeczności, i będziemy to robić przez kolejne dziesięciolecia.

Co się wydarzyło w świecie systemów open source, w tym Linux?

Ostatnio niektórzy dostawcy dystrybucji Linuksa zmienili swoje modele komercyjne, co zmusiło użytkowników do ponownej oceny planów dla posiadanej infrastruktury linuksowej. Na przykład zmiany wprowadzone w systemie CentOS spowodowały, że CentOS 7 osiągnie koniec okresu eksploatacji w czerwcu 2024 r. – bez dodatkowego wsparcia ani aktualizacji. Stanowi to poważne wyzwanie dla przedsiębiorstw, które polegają na CentOS:

- Brak wsparcia i ochrony: Gdy CentOS osiągnie koniec okresu eksploatacji, użytkownicy nie będą już otrzymywać wsparcia, aktualizacji ani poprawek bezpieczeństwa, a ich systemy będą podatne na zagrożenia.

- Brak kompatybilności oprogramowania: Kompatybilność aplikacji i możliwość integracji może być zagrożona, ponieważ oprogramowanie staje się przestarzałe, bez nowych funkcji czy aktualizacji.

Chociaż zmiany te są zgodne z literą licencji GPL, nie są one zgodne z ideą open source. Konkurencja między dostawcami open source nie powinna prowadzić do tego, że firmy te zamykają swój kod i stają się bardziej restrykcyjne w sposobie, w jaki klienci i programiści mogą z niego korzystać. Prowadzi to do uzależnienia się od jednego dostawcy, mniejszej elastyczności i ograniczenia swobody wyboru. Niemniej „koniec życia” systemu to nie koniec drogi.

Co robimy w tej sprawie: SUSE umożliwia wybór

SUSE pozostaje niezłomne w swoim zobowiązaniu do utrzymywania otwartego kodu i wnoszenia wkładu w społeczności, których jest częścią. W ramach oferty SUSE Liberty Linux będziemy utrzymywać i wspierać istniejące systemy CentOS 7 i CentOS 8.5 „takie jakie obecnie są” do 2028 r. – bez konieczności migracji lub innych poważnych zmian. Dysponujemy potrzebnymi narzędziami, usługami, personelem i doświadczeniem. Zapewniamy rozszerzone wsparcie, płynne przejście, kompleksową wiedzę specjalistyczną i obsługę praktycznie wszystkich dystrybucji systemu Linux dla przedsiębiorstw, a także utrzymanie założonego budżetu i uniknięcie wysokich kosztów licencjonowania.

SUSE, poza inwestycjami finansowymi i technicznymi, będzie ściśle współpracować ze społecznością open source, aby zapewnić, że nowy fork będzie trwałą, kompatybilną alternatywą dla użytkowników systemu CentOS.

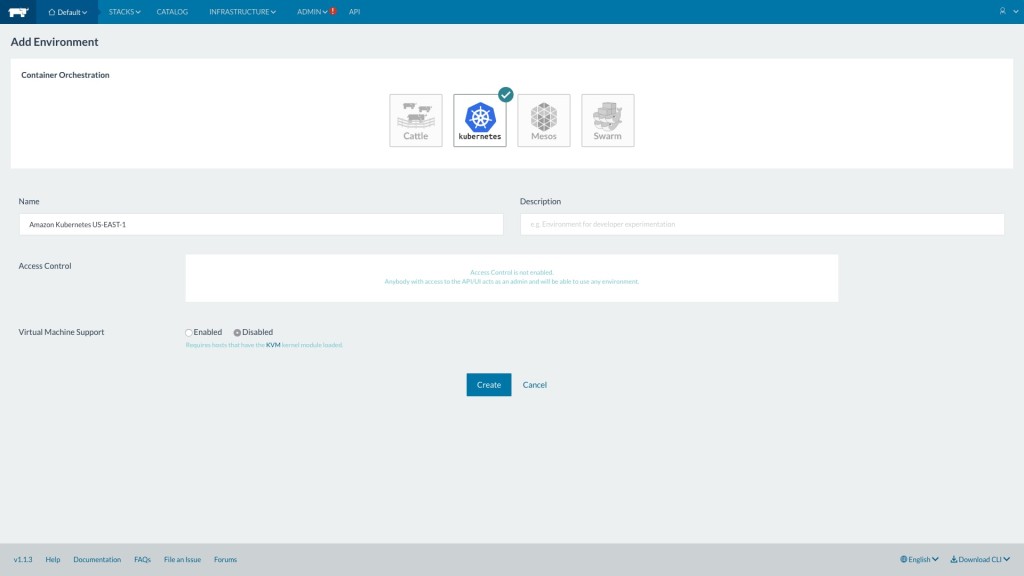

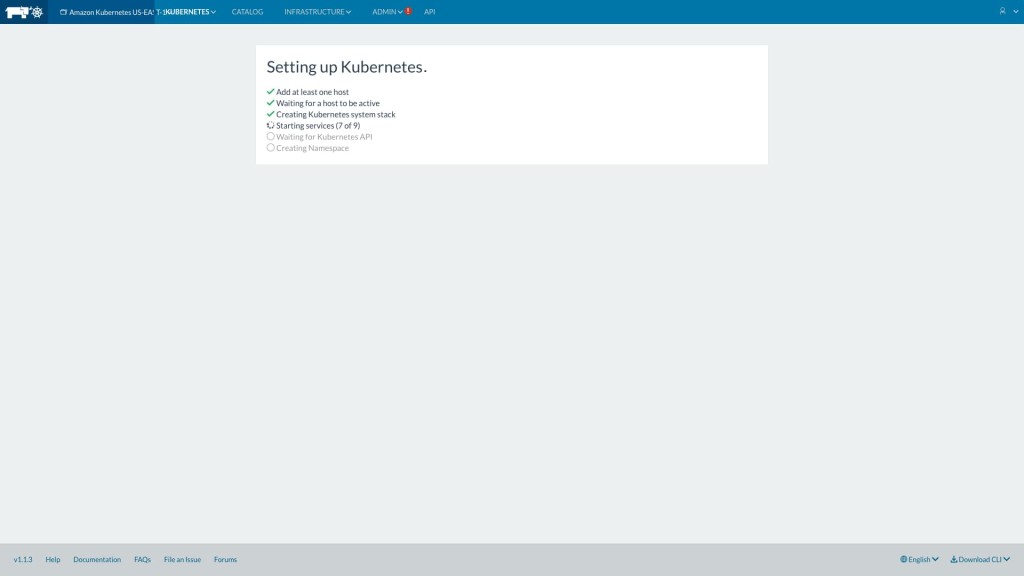

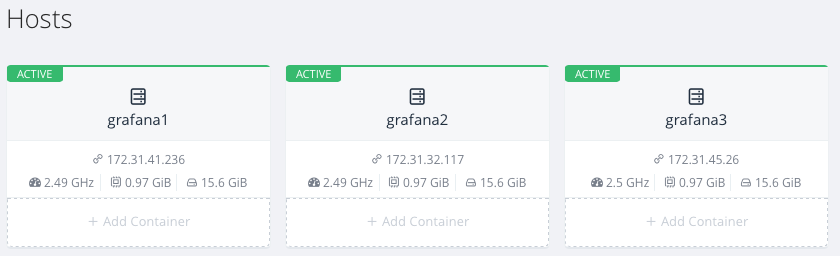

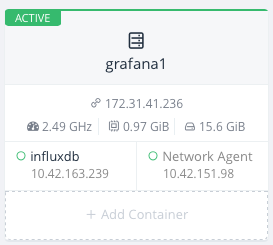

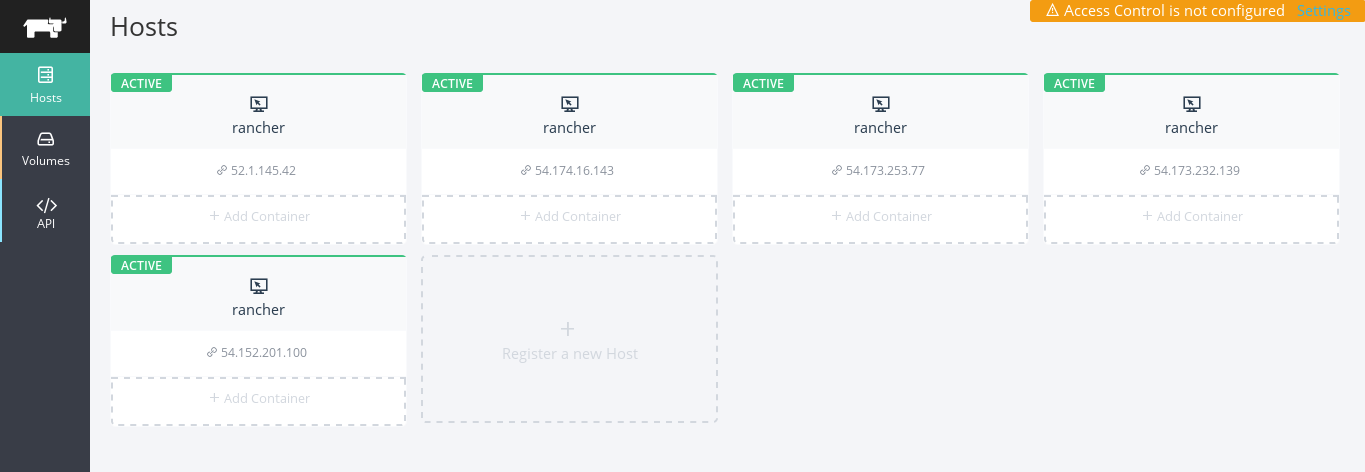

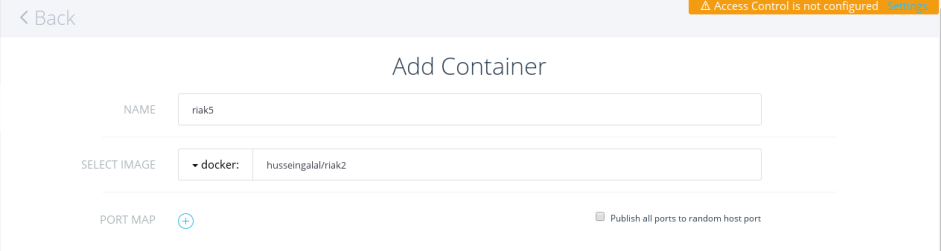

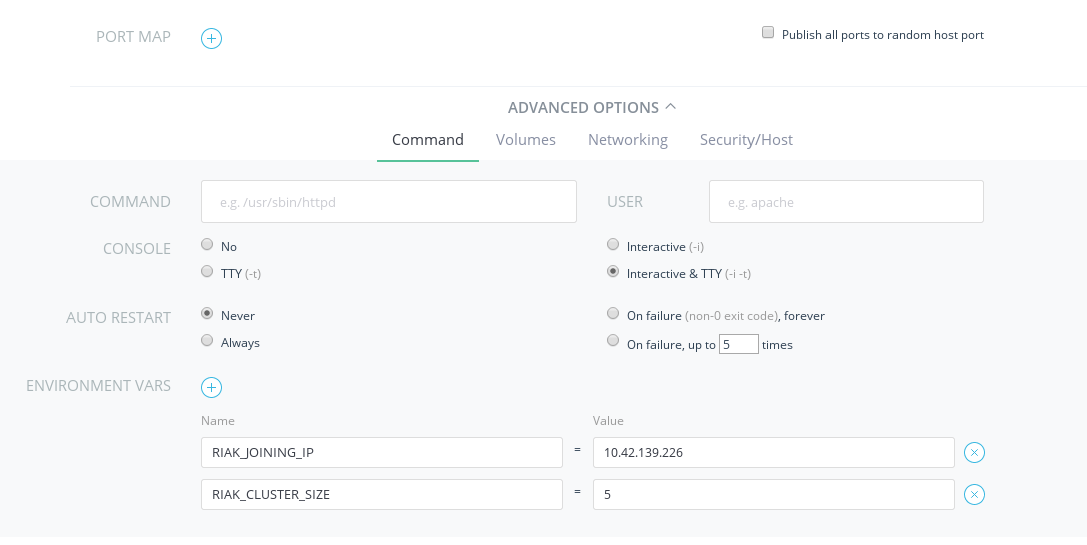

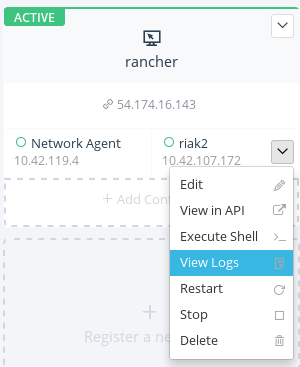

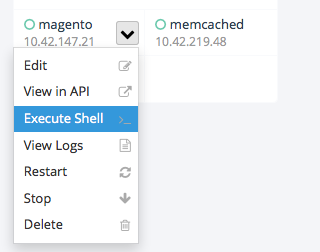

Obiecujemy – jak zawsze – zachować otwarty kod. Docelowo przekażemy projekt fundacji open source, co dodatkowo zagwarantuje bezpłatny dostęp do alternatywnego kodu źródłowego w perspektywie długoterminowej. Jesteśmy zaangażowani w interoperacyjność, otwarte standardy i wsparcie dla środowisk złożonych z różnych technologii, zapewniając wybór, elastyczność i niezawodność. Nasze zaangażowanie w zapewnienie swobody wyboru dotyczy całej naszej oferty produktów i usług, w tym SUSE Linux Enterprise (SLE), SUSE Manager, NeuVector, Rancher i innych. Na przykład SUSE Manager umożliwia zarządzanie ponad 16 dystrybucjami Linuksa, a nie tylko naszymi produktami – wszystko z poziomu jednej konsoli. Szeroka gama naszych narzędzi i usług w połączeniu z bogatą wiedzą i doświadczeniem pozwala nam uprościć złożoność działań operacyjnych związanych z obsługą heterogenicznych środowisk.

Jakie działania warto podjąć w obliczu zmian w otoczeniu?

CIO i wszyscy inni menedżerowie odpowiedzialni za IT zdają sobie sprawę z konieczności zagwarantowania swojej firmie, że wybrani przez nich dostawcy będą dostarczać swoje technologie w sposób jasny i klarowny. Nadszedł więc odpowiedni czas na ponowną ocenę sytuacji i optymalizację działań w celu zapewnienia elastyczności i swobody wyboru w przyszłości. To czas na:

- Wybór prawdziwie otwartych narzędzi open source i usług, które są wspierane przez dostawcę zaangażowanego w opracowywanie w pełni otwartego oprogramowania.

- Współpracę z zaufanymi partnerami i społecznościami open source, które kierują się takimi wartościami jak współpraca i wspólny sukces. Należy upewnić się, że partnerzy ci dysponują odpowiednią kadrą i zakresem usług, by pomóc w realizacji strategii klienta.

- Nadanie najwyższego priorytetu dla zapewnienia możliwości wyboru, elastyczności, niezawodności i elastyczności, tak aby odzyskać kontrolę nad środowiskami Linux i całą infrastrukturą IT.

Realia środowisk złożonych z różnych technologii i pomoc SUSE w ich obsłudze

To fakt, że większość działów IT w przedsiębiorstwach stawia na środowiska mieszane (heterogeniczne). Ma to po prostu sens biznesowy – a open source jest jednym z kluczowych elementów umożliwiających takie podejście. Środowiska mieszane z założenia promują swobodę wyboru i zapewniają elastyczność organizacji – dwa absolutne wymogi w dzisiejszych dynamicznych środowiskach biznesowych. Poniżej znajduje się podsumowanie kilku ważnych zalet środowisk mieszanych oraz przykłady wspierania ich przez rozwiązania SUSE.

1. Redundancja i niezawodność

Modele mieszane lub hybrydowe pozwalają organizacjom skutecznie rozłożyć ryzyko na wiele środowisk, zapewniając tym samym ciągłość działania w przypadku awarii jednego z systemów. Kontrastuje to z podejściem homogenicznym, które stwarza większe ryzyko, że pojedynczy punkt awarii spowoduje awarię wszystkich systemów.

SUSE Manager jest tutaj doskonałym przykładem, ponieważ obsługuje szeroką gamę dystrybucji Linuksa, niezależnie od ich rozmieszczenia. I obsługuje wszystko z poziomu jednej konsoli, dzięki czemu użytkownik ma pełny wgląd w swoje środowisko.

2. Innowacyjność i elastyczność

Korzystanie z różnorodnych środowisk sprzyja zdrowej konkurencji pomiędzy firmami open source i innymi dostawcami, a także przyspiesza tempo opracowywania nowych rozwiązań i ulepszeń. Ma to kluczowe znaczenie dla osób opowiadających w firmie za IT i wybór technologii, ponieważ sami znajdują się pod coraz większą presją szybszego i częstszego dostarczania nowych produktów i usług dla swojej organizacji.

SUSE Linux Enterprise (SLE) jest dobrym przykładem rozwiązania stworzonego z myślą o środowiskach mieszanych. SLE oferuje sprawdzoną, bezpieczną, elastyczną i łatwą w zarządzaniu platformę serwerową i desktopową, która umożliwia zarówno programistom, jak i administratorom uruchamianie zadań w dowolnym miejscu – lokalnie, w chmurze lub na brzegu sieci – odzwierciedlając rzeczywistość, w której dzisiejsze środowiska technologiczne przedsiębiorstw muszą działać wszędzie. Umożliwia to ciągłe wprowadzanie innowacji przy jednoczesnym zachowaniu bezpieczeństwa, odporności i niezawodności.

3. Zapobieganie uzależnieniu od dostawcy

W środowiskach mieszanych liczy się przede wszystkim swoboda wyboru i kontrola. Użytkownik zachowuje krótko- i długoterminową swobodę, a jego zasoby nie są uzależnione od jednego dostawcy. Jeśli któryś dostawca wprowadzi zmiany, które nie są zgodne z wizją klienta, łatwiej i szybciej można się do nich dostosować, ponieważ dostępne są już inne opcje. Takie podejście prowadzi też do optymalizacji kosztów, co jest zaletą środowisk mieszanych.

SUSE Liberty Linux jest tutaj doskonałym przykładem. To solidne rozwiązanie technologiczne i powiązane z nim usługi wsparcia dla całego środowiska Linux, które eliminuje przywiązanie do jednego dostawcy. SUSE Liberty Linux zapewnia pełne wsparcie dla całego środowiska Linux – bez migracji. Co więcej, SUSE oferuje bardzo dobry, długoterminowy serwis i wsparcie w zakresie wszystkich technologii, a także usługi migracji i opcje wsparcia w trybie „białych rękawiczek”, zapewniając specjalistyczną wiedzę i pewny sukces projektów opartych na open source.

Uwaga użytkownicy CentOS: nadszedł czas na działanie

Dla wielu użytkowników systemów CentOS przejście na inną dystrybucję Linuksa nie jest realną opcją – oznacza potencjalne problemy z migracją, przerwy w działaniu, problemy z kompatybilnością oprogramowania i konieczność przeszkolenia personelu z zarządzania nowym środowiskiem. To jeden z głównych powodów, dla których podwajamy nasze długoterminowe zaangażowanie we wspieranie użytkowników systemu CentOS. Przejście na SUSE Liberty Linux nie wymaga migracji.

Zapewniamy narzędzia, usługi i wyszkolony personel, co gwarantuje płynne przejście już teraz. Mamy też zasoby do realizacji na dużą skalę najbardziej ambitnych celów w przyszłości. Rozwiązania SUSE to:

- Bezpieczeństwo: Dalsze korzystanie z systemów CentOS 7 i 8.5 w obecnej postaci – po zakończeniu okresu eksploatacji (EOL) i bez zapewnionego wsparcia – stwarza poważne ryzyko dla bezpieczeństwa i wyzwania w zakresie zgodności z przepisami. Zobowiązujemy się do zapewnienia pełnego wsparcia dla tych systemów i ich aktualizacji do 2028 roku.

- Autonomia i zabezpieczenie na przyszłość: Firma SUSE służy pomocą nie tylko teraz. Będziemy do dyspozycji niezależnie od tego, co przyniesie przyszłość. Nasi klienci zachowują kontrolę i elastyczność. Ich systemy Linux są bezpieczne, zaktualizowane i nowatorskie.

- Kompleksowe wsparcie: Zapewnimy niezrównane usługi wsparcia i obsługę różnorodnych systemów Linux dla firm.

- Zaangażowanie w open source: SUSE od ponad trzech dekad zajmuje się tworzeniem i wspieraniem rozwiązań open source. Nigdy nie stracimy z oczu naszych korzeni i pozostaniemy w 100% oddani ideom otwartego oprogramowania.

Podsumowanie

W przypadku stosowania systemów Linux do wspierania działalności swojej organizacji, warto polegać na firmie SUSE, która zapewnia doskonałą obsługę klienta i rozwiązuje najtrudniejsze problemy techniczne. Nasze zaangażowanie w oprogramowanie open source i sukces naszych klientów nigdy nie zmalało – i nigdy nie zmaleje! Więcej informacji można znaleźć na stronie o SUSE Liberty Linux:

https://www.suse.com/products/suse-liberty-linux